之前我分享了一些Flux模型的在线体验方法。今天,我将介绍如何在本地部署Flux.1 dev GGUF工作流。

一、GGUF简介

GGUF,全称GPT-Generated Unified Format,是一种为大型语言模型设计的二进制文件格式。由llama.cpp创始人Georgi Gerganov提出,优化了数据结构和编码方式,显著提升了模型文件的存储效率和加载性能。

下载地址:https://github.com/XLabs-AI/x-flux-comfyui

在Github上,XLabs-AI官方也推荐在低内存环境下使用GGUF格式。

二、Flux.1 dev GGUF工作流部署

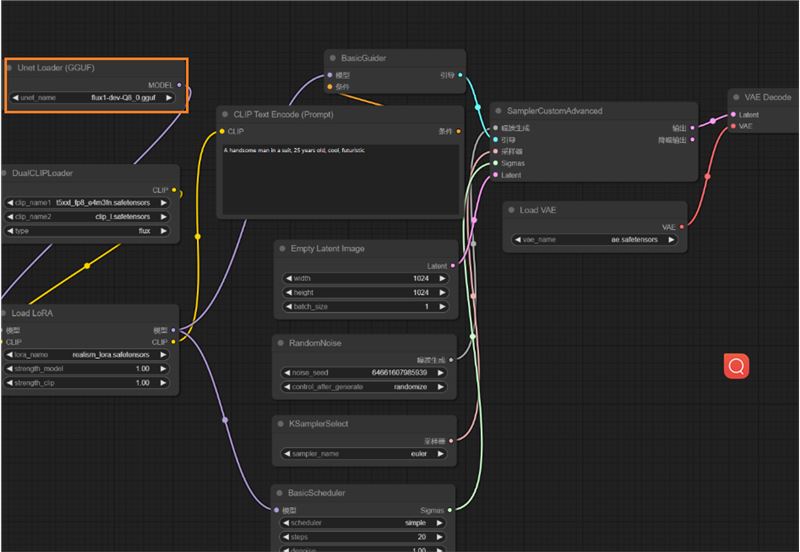

以一个典型的ComfyUI Flux.1 dev GGUF工作流为例,详细说明部署步骤。

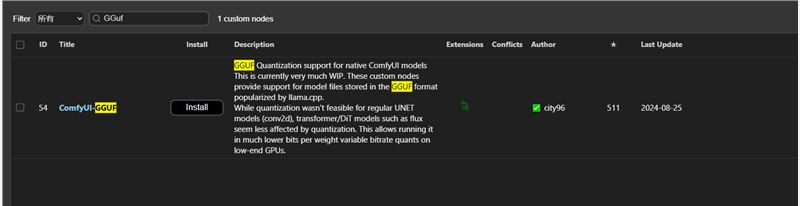

插件安装

插件地址:https://github.com/city96/ComfyUI-GGUF

可以手动安装或者在管理器安装

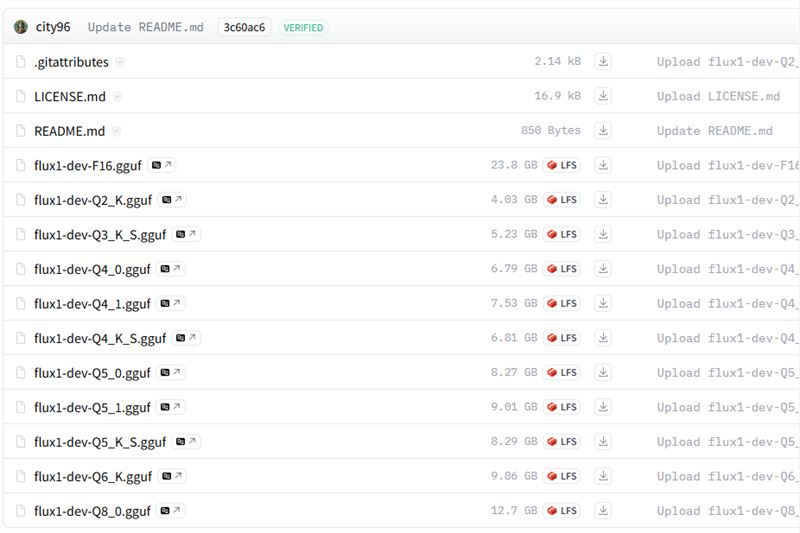

模型下载

下载地址:https://github.com/XLabs-AI/x-flux-comfyui

但是首页上这么多模型我们该下载哪个呢,经过网络上各个大佬的测评得出的比较推荐的有Q40和Q80的两个模型

将模型放置在ComfyUI/models/unet目录下。

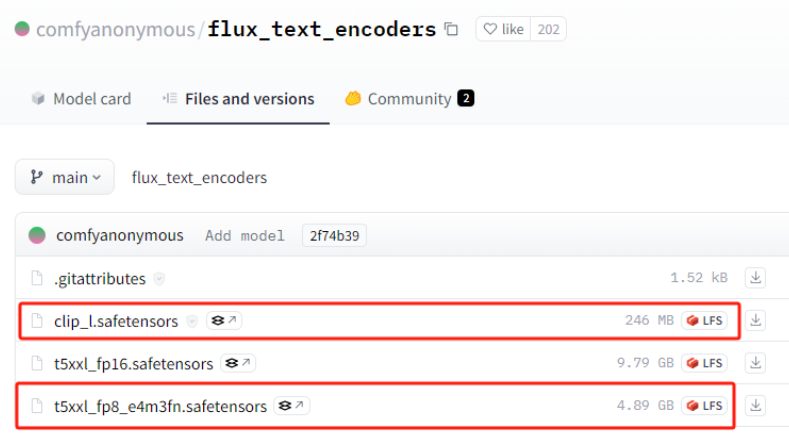

CLIP模型下载

地址:https://huggingface.co/comfyanonymous/flux_text_encoders/tree/main

下载所需文件放置在ComfyUI/models/clip目录下。

之前有本地部署过Flux的应该都已经下过了。

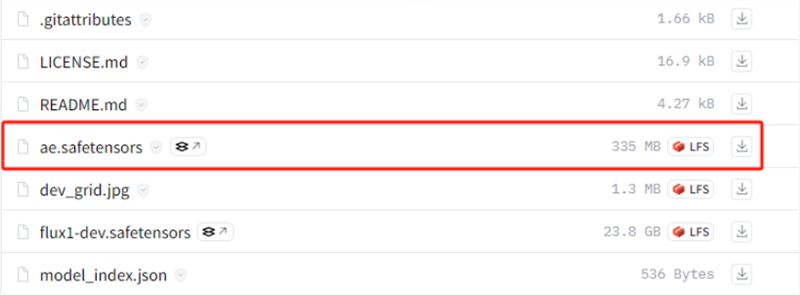

VAE模型下载

地址:https://huggingface.co/black-forest-labs/FLUX.1-dev/tree/main

下载文件放置在ComfyUI/models/vae目录下。

这个之前部署过的小伙伴肯定也不陌生

LORA模型下载(可选)

地址:https://huggingface.co/XLabs-AI/flux-lora-collection/tree/main

下载所需LORA模型放置在ComfyUI/models/loras目录下。

使用工作流

启动ComfyUI,修改我们之前Flux官方工作流文件,把模型加载器换GGUF的模型加载器即可使用。

注意:Flux.1 dev和Flux.1 dev GGUF工作流的主要区别在于使用的节点不同。感兴趣的小伙伴赶紧去安装吧

2

文章目录

一、GGUF简介

二、Flux.1 dev GGUF工作流部署

使用工作流

AI教程交流群

扫描二维码加入群聊

与同行学习交流&资源共通

© CopyRight 2002-2024 ,CHINAZ.COM , Inc.All Rights Reserved.