最近在用Flux模型的时候发现有的Fp8 是用Checkpoints加载而有的又是用unet加载,我以为只是文件路径不同,我就把我的fp8 模型放在checkpoints文件夹内,然而加载的时候竟然报错了。我仔细研究了一下原来是flux的模型太多了,如果你也和我一样遇到类似的问题,或者对使用哪个加载器傻傻分不清楚可以认真看看这篇哦

图片来源:B站UP主(甜小言BLK)

Checkpoints版本

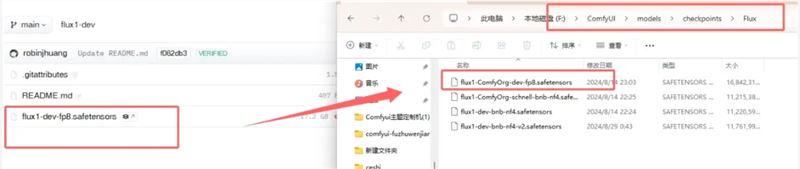

- Comfy Org-fp8 版本

Comfyui官方推出的 3 合一版本,大概17G,模型已经集成Clip,直接使用checkpoints加载器就可以使用

下载地址:https://huggingface.co/Comfy-Org/flux1-dev/tree/main

- Flux-NF4 版本

大概率要被弃用的版本,也是集成了Clip模型,有分V1,V2 版本,推荐使用V2,而且需要配合插件使用

插件下载:https://github.com/comfyanonymous/ComfyUI_bitsandbytes_NF4

模型下载:https://huggingface.co/lllyasviel/flux1-dev-bnb-nf4/tree/main

unet版本

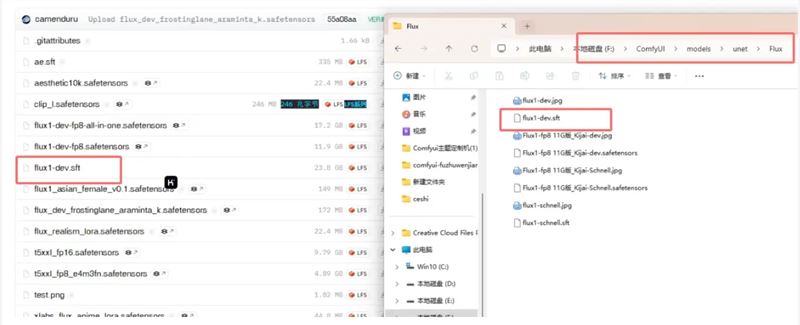

- 黑森林原版FP16

就是最大的那个23G的模型,质量也算最高,需要配合两个Clip模型和Vae使用

模型下载:https://huggingface.co/black-forest-labs/FLUX.1-dev/tree/main

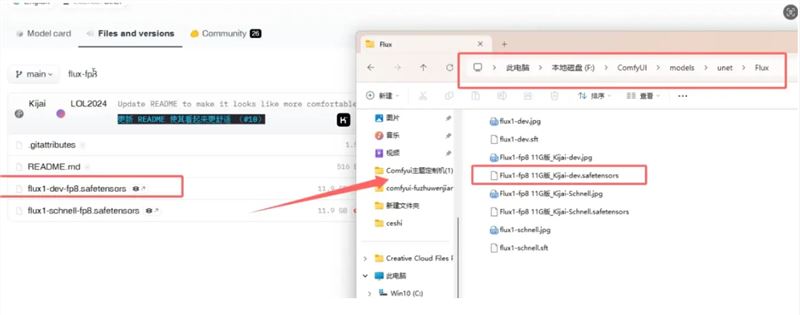

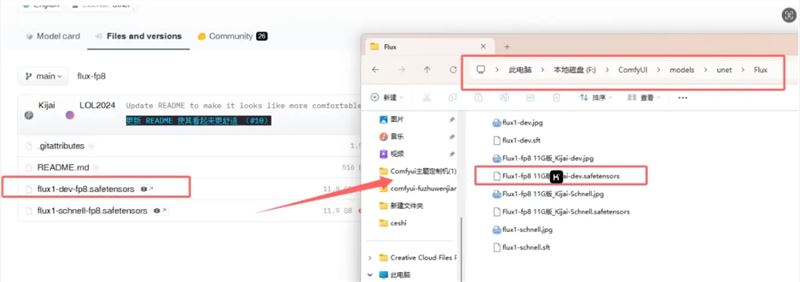

- Kijia-FP8 版

KJ大佬制作的11G左右的模型,也需要配合两个Clip模型和Vae使用

模型下载:https://huggingface.co/Kijai/flux-fp8/tree/main

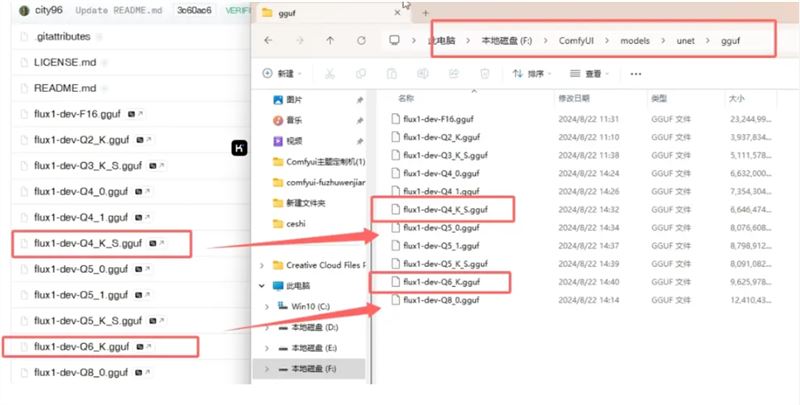

- 量化模型-gguf版

最适合低显存的模型,也需要配合插件使用,有 11 个版本,推荐Q4,Q8 版本的

模型下载:https://huggingface.co/city96/FLUX.1-dev-gguf/tree/main

模型文件路径

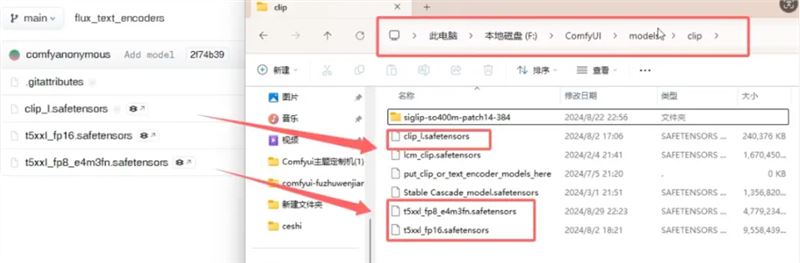

Clip模型路径:

ComfyUI官方出的三合一Flux模型:

GGUF模型:

KJ版的FP8:

NF4 模型:

黑森林官方版本:

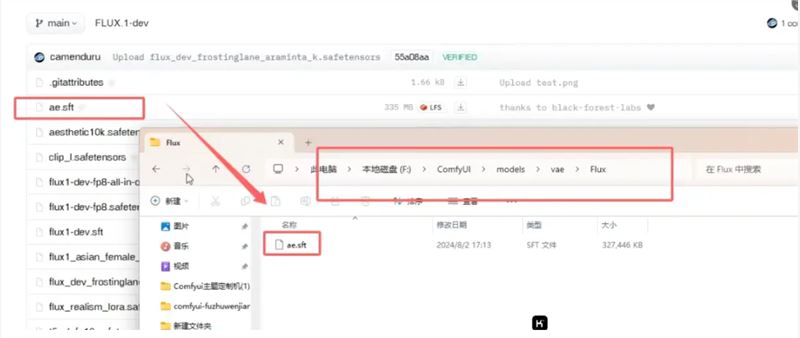

VAE模型:

以上截图来源:B站UP主(甜小言BLK)

我遇到的问题就是把【Comfy Org-fp8 版本】和【Kijia-FP8 版】版本搞错了,因为他俩的名字是一模一样的

最后推荐模型:如果你显存16G以上版本都可以任选,推荐FP8(KJ和ComfyUI的都可以,只是ComfyUI出的比较方便加载)

如果你显存8-12G:首推NF4V2 版本,其次是gguf-Q4,不过看网上测评gguf的模型速度又慢质量也不好

3

© CopyRight 2002-2024 ,CHINAZ.COM , Inc.All Rights Reserved.