ComfyUI免费图生视频 CogvideoX-I2V 工作流,CogvideoX本地部署教程

9/23/2024, 9:44:50 AM | 热度:1113 | 阅读本文需 2 分钟

点赞

分享一下清华大学最近开源的CogVideoX-5b-I2V图片生成视频的模型,这个模型可以将一张图像作为背景输入,结合提示词一起生成视频,比文本生成视频具有更强的可控性,根据官方的介绍,采用bf16 精度进行推理,单卡只需要5G显存即可以愉快的玩耍,让我们本地部署一下

在线体验:https://huggingface.co/spaces/THUDM/CogVideoX-5B-Space

Github:https://github.com/THUDM/CogVideo

模型权重:https://huggingface.co/THUDM/CogVideoX-5b-I2V

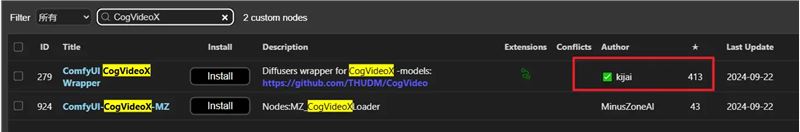

ComfyUI插件安装

目前管理器已经有两款插件支持,我们可以使用KJ大佬的插件

插件地址:kijai/ComfyUI-CogVideoXWrapper (github.com)

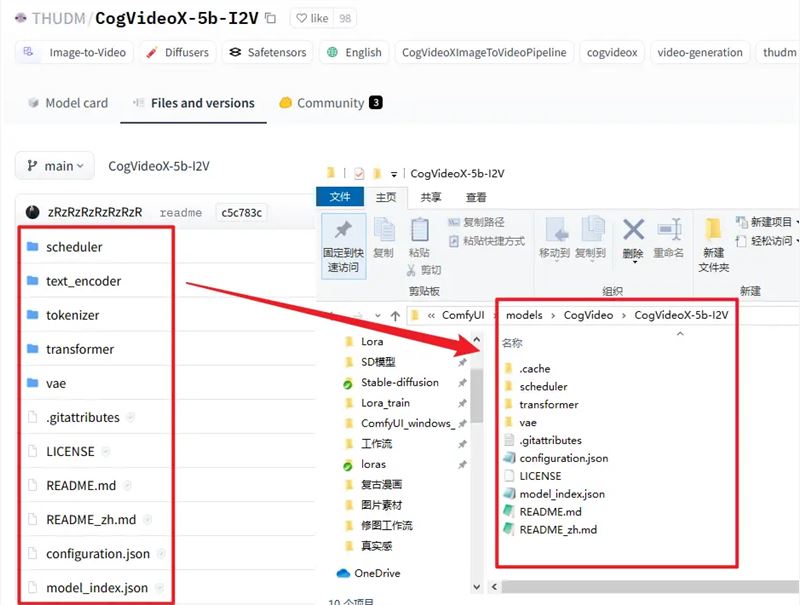

模型下载

然后我们需要下载模型,如果你网络通畅运行工作流会自动下载模型,如果你是手动下载就放到一下文件夹内即可

模型CogVideoX-5b-I2V:https://huggingface.co/THUDM/CogVideoX-5b-I2V

模型放置位置:

你需要把全部文件下载至下图的路径中

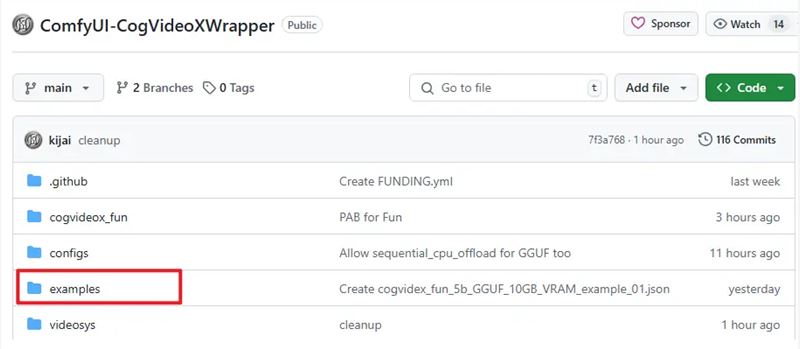

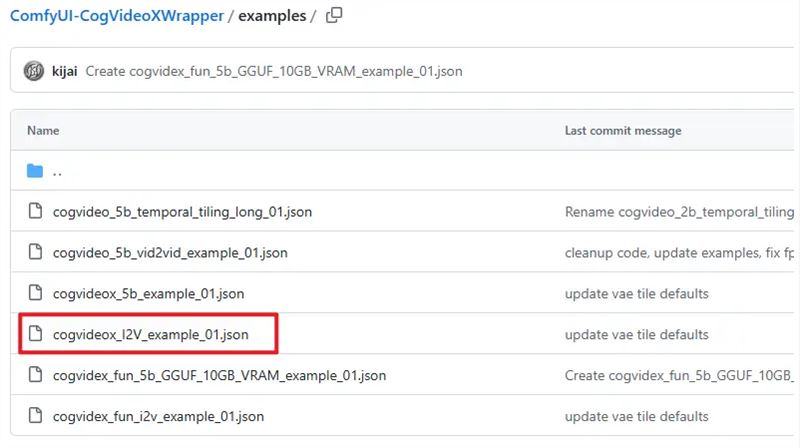

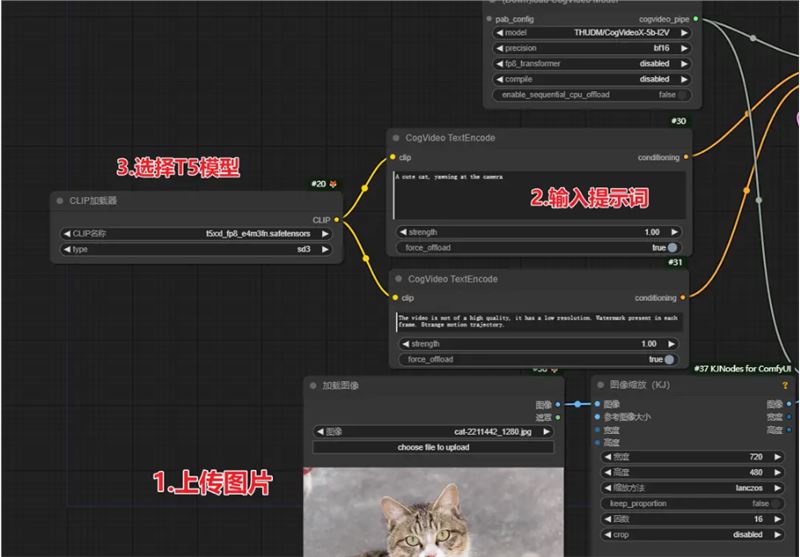

工作流说明

插件作者已经提供了示例的工作流,我测试使用的是I2V的工作流,也就是图像转视频

工作流需自己修改的地方:

T5模型就是Flux常用的那个Clip模型,下载地址,大家选择fp8的就可以:https://huggingface.co/comfyanonymous/flux_text_encoders/tree/main

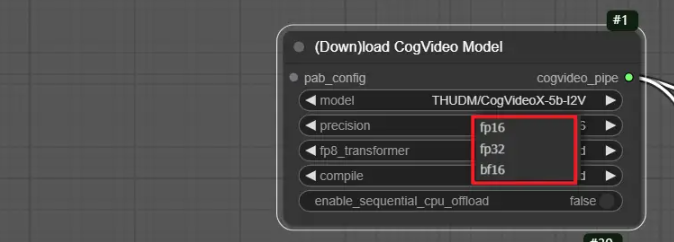

目前只支持720* 480 的尺寸,所以有个图像缩放节点。下载模型的精度排的越后精度越高,性能要求更大,我这里测试的是bf16 的精度

github也有对模型和精度进行介绍,大家也可以参考一下

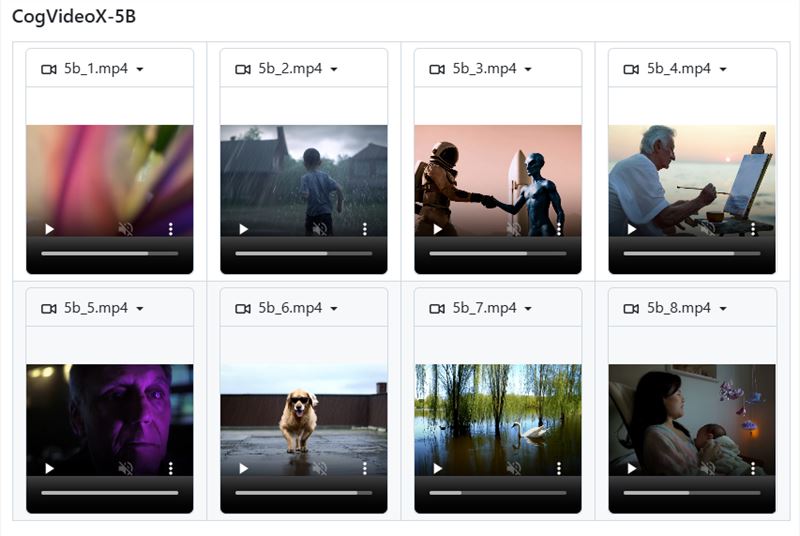

视频效果

网站不能上传视频,所以这边就放点Gif,Gif画质会有很大压缩,所以大家主要看看运动的效果,实际ComfyUI生成的画质会好得多

更多示例大家可以去github首页看官方发布的参考视频,效果都挺不错的

2

© CopyRight 2002-2024 ,CHINAZ.COM , Inc.All Rights Reserved.