苹果开源!专业级深度Depth Pro,毫秒级速度,对比Depth Anything效果测评

10/8/2024, 4:20:42 PM | 热度:232 | 阅读本文需 2 分钟

点赞

在国庆期间,苹果公司开源了一款深度图的模型, 注于从单张图像生成精确的深度图。

项目地址:https://github.com/apple/ml-depth-pro

主要特点包括:

速度与分辨率:该模型能在0. 3 秒内生成2. 25 百万像素的深度图,运行在标准GPU上,效率极高。

边界精度与锐利度:通过使用多尺度视觉Transformer,以及训练过程中结合真实和合成数据集,模型在对象边缘生成准确且高频的细节。

无需预先摄像机数据:该模型无需先验摄像机内参等元数据,具有广泛的适用性。

焦距估计:除了生成深度图,该模型还能从图像中直接估算焦距。

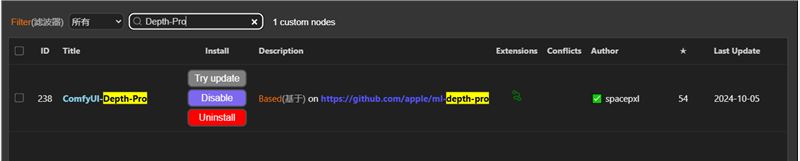

插件安装

很快就有大佬在 ComfyUI 上支持了这款模型并且制作了工作流

插件地址:https://github.com/spacepxl/ComfyUI-Depth-Pro?tab=readme-ov-file

插件安装:直接在管理器上搜索 Depth-Pro 即可安装

使用方法

示例工作流在插件地址的 example 文件夹中,我们下载直接拖入 comfyui 即可

第一次运行会自动帮我们下载模型,所以请保证网络通畅,如果自动下载失败也可以选择手动下载模型到以下文件夹内

ComfyUI/models/depth/ml-depth-pro/

模型下载链接:https://huggingface.co/spacepxl/ml-depth-pro/blob/main/depth_pro.fp16.safetensors

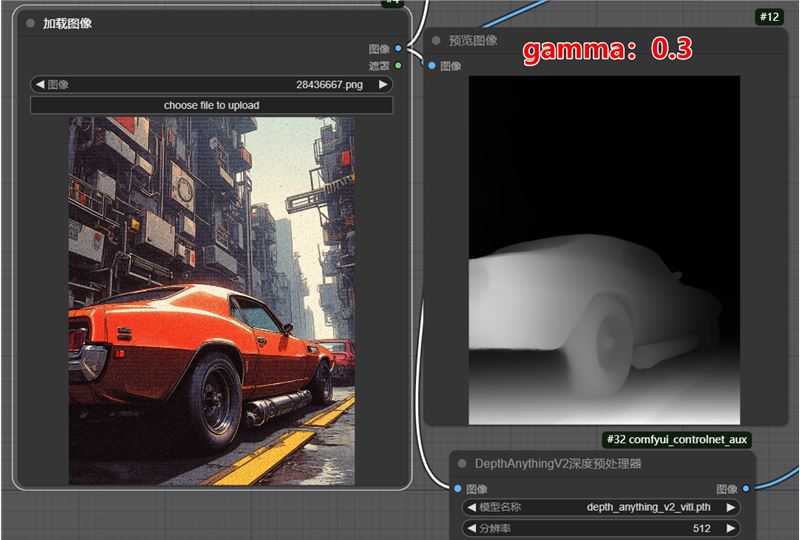

相比于一般的 Depth 节点,该节点需要我们手动调节 gamma 值来获取更好的效果

伽马值越高背景越亮,细节也会更多一些,伽马值越低背景就越暗,主体会更突出。具体的对比可以看下面 两 图

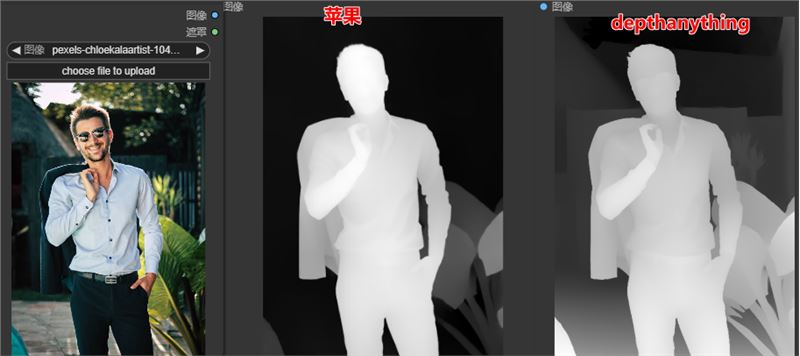

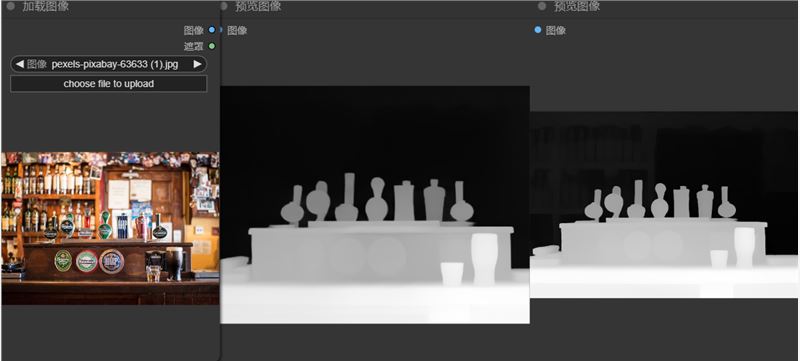

与 DepthAnythingV2 模型对比

苹果的优点是速度非常快,几乎是 2,3s 之内就可以处理完一张图,但是有时候会缺失背景细节(即使开到更高的 gamma 值)

关于模型的选择,我的建议是按需使用,如果你不喜欢有原图的背景干扰并且对速度有要求,可以使用苹果的模型,通过调整伽马值来获取更清晰的前景

如果你就是想还原或者重绘原图的场景使用DepthAnything可能会更好一些

1

© CopyRight 2002-2024 ,CHINAZ.COM , Inc.All Rights Reserved.