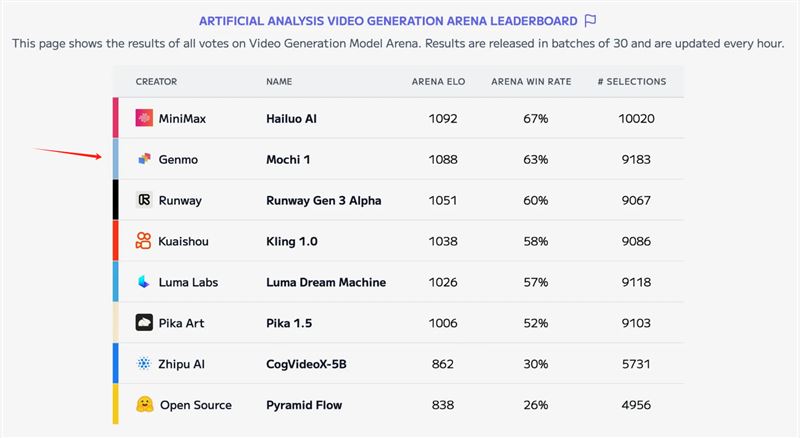

Mochi 有多厉害大家可以看一下这个视频效果:

在线使用地址:https://www.genmo.ai/play

开源模型地址:https://huggingface.co/genmo/mochi-1-preview

使用方法

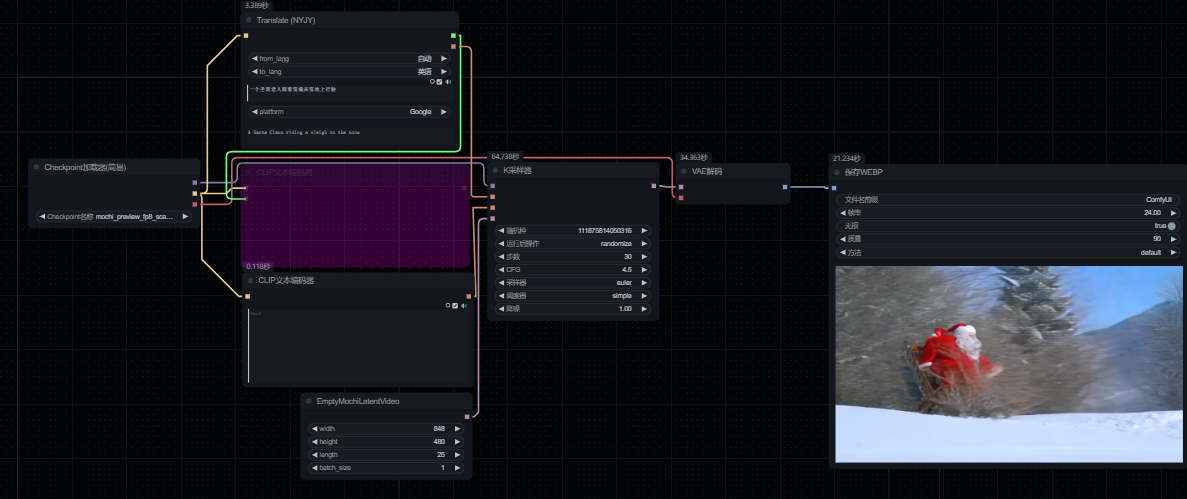

前些天 ComfyUI 更新了一次,现在优化了对 Genmo 最新型号 Mochi 的支持!这种集成为 ComfyUI 社区带来了最先进的视频生成功能,即使您使用的是消费级 GPU。

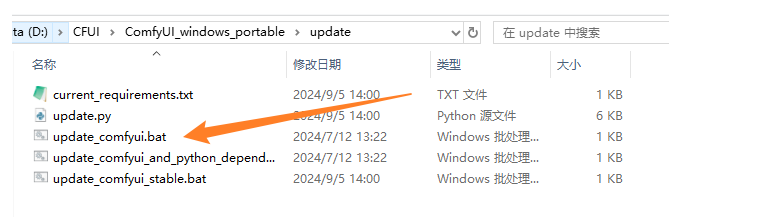

原生包更新:

通过以下步骤,使用标准工作流程立即运行 Mochi 模型。

更新到最新版本的 ComfyUI

将 Mochi 模型下载到:

models/diffusion_models把 Clip 下载到:

models/clip将 VAE: 下载到:

ComfyUI/models/vae查找示例工作流程:

https://comfyanonymous.github.io/ComfyUI_examples/mochi/?ref=blog.comfy.org

低 RAM 解决方案

如果您遇到 RAM 不足的情况,我们建议您在使用上述工作流程时执行以下步骤:

切换编码器:尝试使用 fp8 缩放模型作为 t5xxl_fp16 的替代方法

切换扩散模型:使用 mochi_fp8 作为 bf16 模型的替代项。

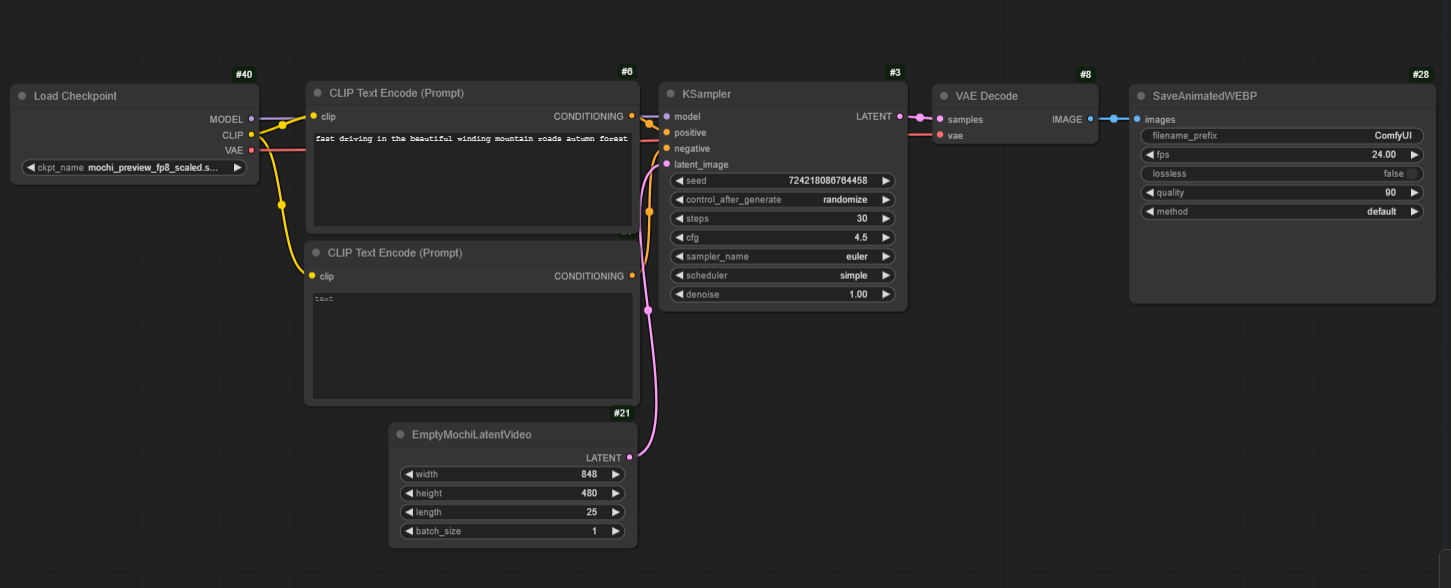

官方工作流

ComfyUI 团队还为准备了一个 all-in-one 打包的 checkpoint,整合了文本编码器和 VAE 配置。请尝试以下步骤:

将三合一的模型下载到文件夹

models/checkpoint下载地址:https://huggingface.co/Comfy-Org/mochi_preview_repackaged/tree/main/all_in_one?ref=blog.comfy.org

按上述方式运行简化的视频生成工作流程。

大家感兴趣的可以去看 ComfyUI 的博客也有详细的介绍:Run Mochi in ComfyUI with consumer GPU

2

© CopyRight 2002-2024 ,CHINAZ.COM , Inc.All Rights Reserved.