comfyui实战:Redux+Fill实现“万物迁移”

4/16/2025, 8:59:02 AM | 热度:904 | 阅读本文需 7 分钟

点赞

今天我们来玩点有趣的ComfyUI魔法,它是黑森林工作室 (Black Forest labs) 的强大Flux Tools,运用先进的图文适配器 Redux 和图像修复/融合器Fill,配合Flux. 1系列模型,这套组合能让你轻松实现“万物迁移”——将任意元素从一张图(主体A)“瞬移”并完美融入另一张图(场景B)的指定区域。

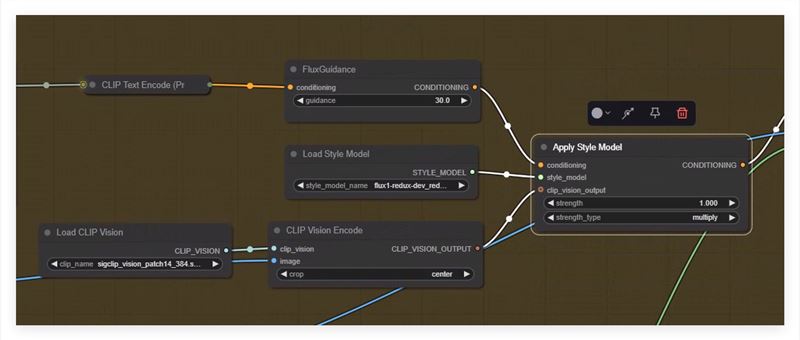

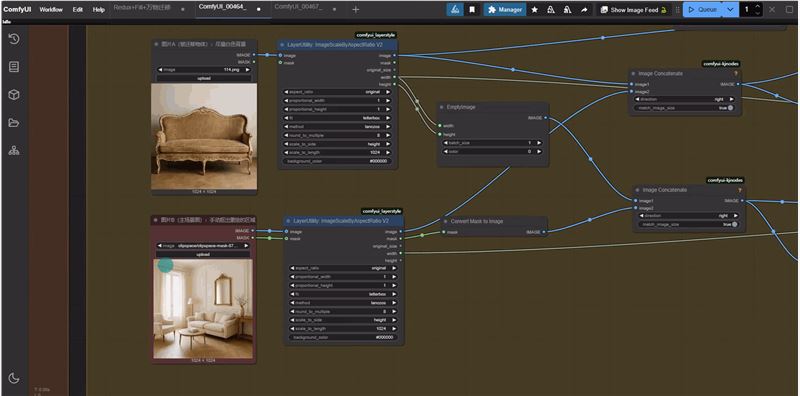

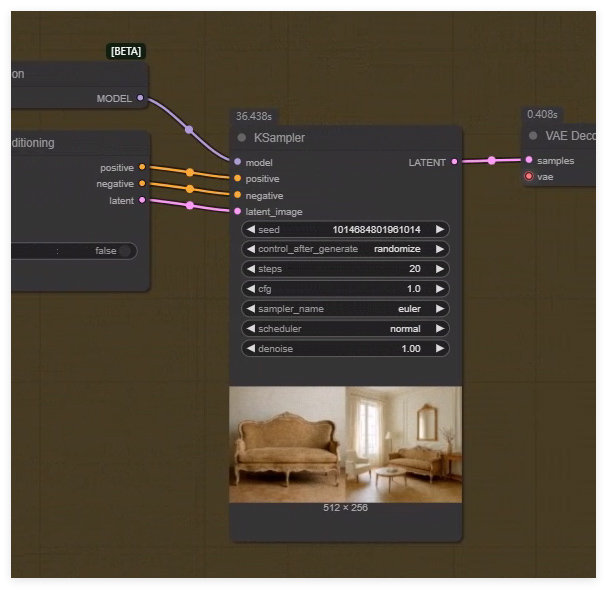

一、核心原理拆解(对照工作流图):

被迁移物体 (图A): 左上角 Load Image 加载了我们要“借用”的复古沙发图片。

目标场景与区域 (图B + Mask): 左下角Load Image加载了客厅场景图。我们已为图B创建了一个遮罩 (图中下方有遮罩预览,涂色区域就是要被替换的地方),精准定位了原场景中需要被替换的沙发区域。

智能融合三部曲 (Redux理解 + Fill绘制 + Flux执行):

1.Redux 理解主体:

Load Style Model加载flux1-redux-dev.safetensors (Redux核心)。

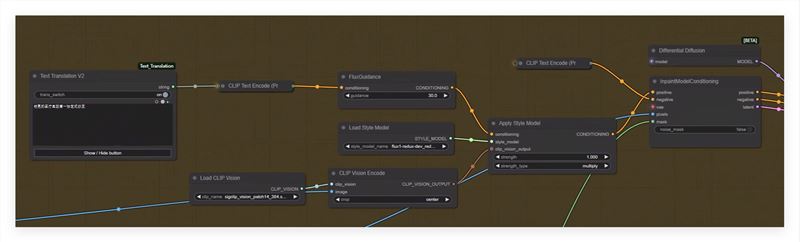

Load CLIP Vision加载SigLIP视觉模型。

CLIP Vision Encode"读取并理解图A (复古沙发) 的视觉特征。

Apply Style Model将文本提示的意图 (来自FluxGuidance)、Redux模型本身、以及从图A提取的视觉信息三者结合,生成一个带有复古沙发“风格烙印”的增强版Conditioning。

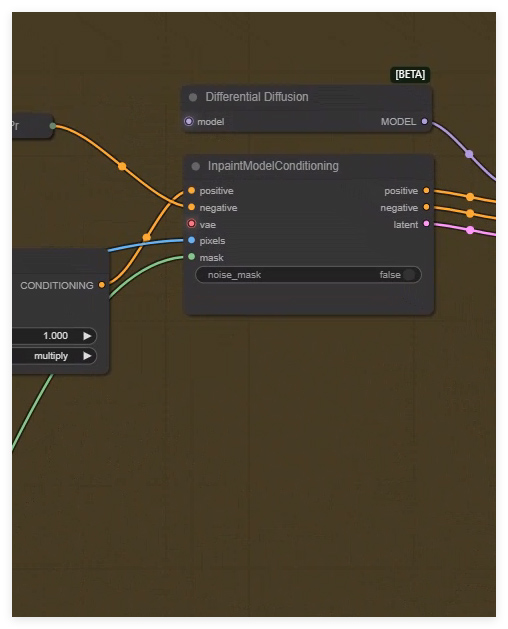

2.Fill定位绘制 (通过 Inpainting 实现):

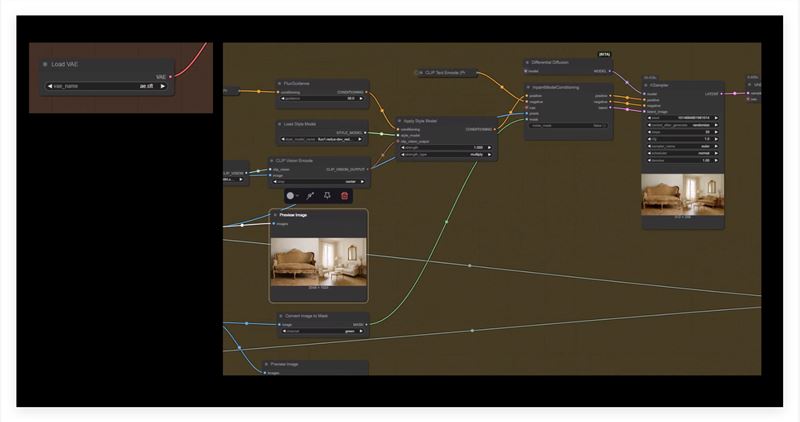

Load Diffusion Model加载 flux1-fill-dev.safetensors,这是负责在新位置“画”出沙发的模型。

InpaintModelConditioning是关键的“调度中心”:它接收来自 Redux的增强版 Positive Conditioning、普通的Negative Conditioning、图B (客厅场景) 的Latent、以及我们创建的Mask。它告诉KSampler:“在Mask区域内,按照这个增强版Conditioning的指示来画”。

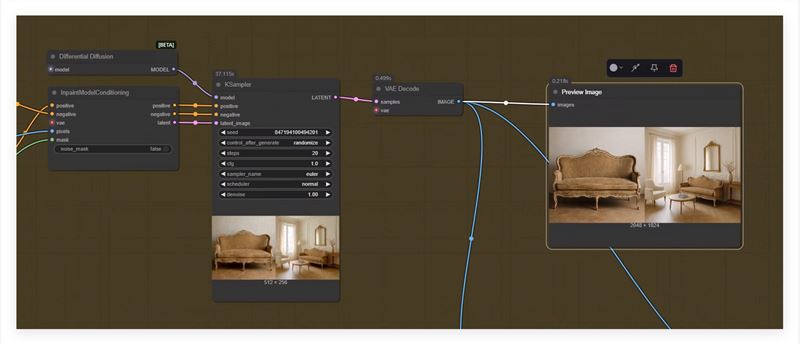

3.Flux执行生成:

KSampler使用Flux Fill模型,在InpaintModelConditioning的精确指导下,在图B的Latent基础上,对Mask覆盖的区域进行重绘 (denoise: 1.00 表示完全重画该区域),将复古沙发“绘制”进去。

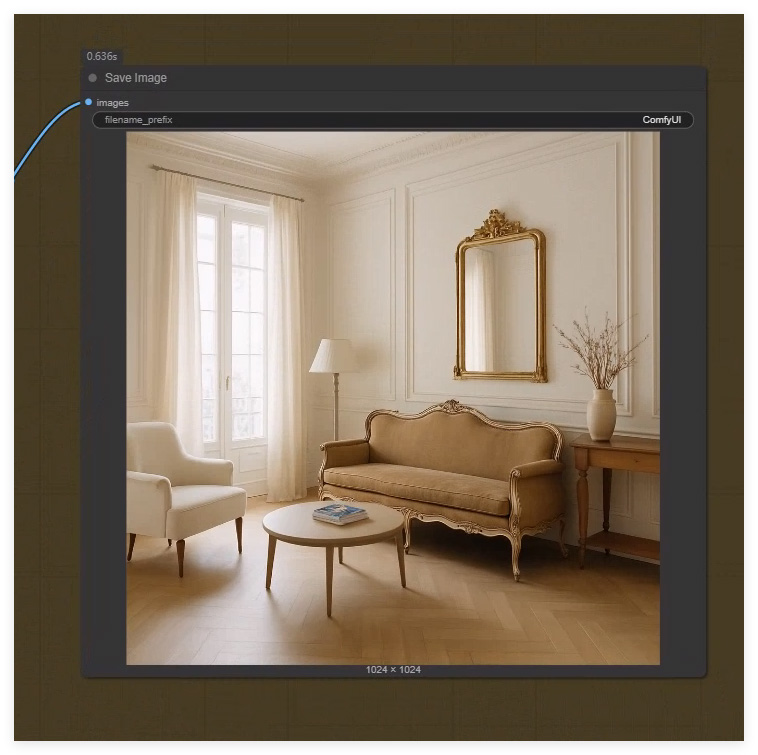

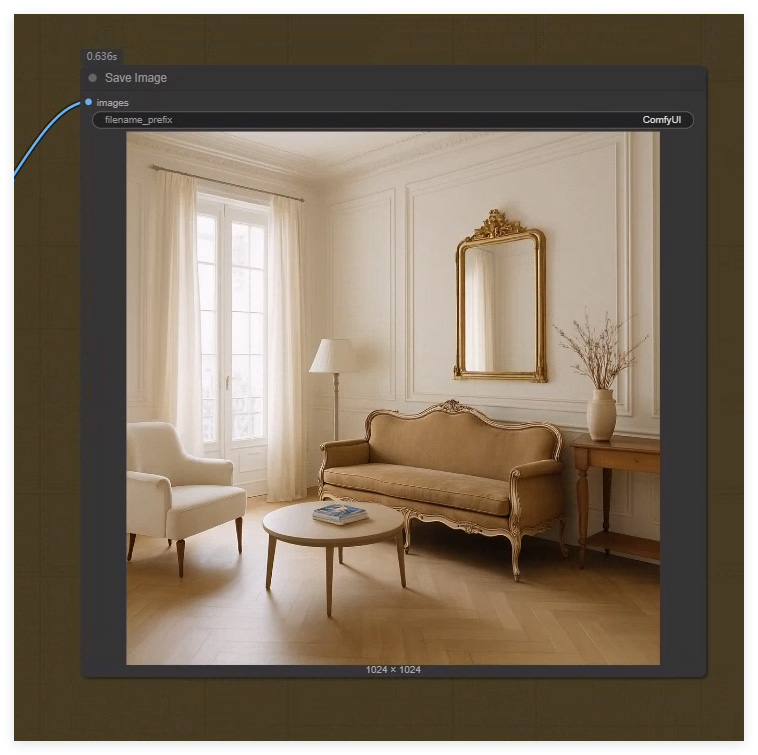

结果呈现: VAE Decode解码生成结果,最终在右上角的Preview Image中看到完美融合的效果图。

二、准备工作

开始操作前,请确保:

1.确保你已经升级到了最新版本的 ComfyUI。

2.安装节点包: 搜索并安装 FLUX.1 Tools。可能还需要ComfyUI-Essentials, LayerUtility 等。

3.下载模型 :

Flux Fill模型: flux1-fill-dev.safetensors (用于Load Diffusion Model)。

Flux Redux模型: flux1-redux-dev.safetensors (用于Load Style Model)。

Text Encoders: T5-XXL (t5xxl_fp8_e4m3fn.safetensors) 和 CLIP-L (clipL.safetensors)。

CLIP Vision 模型: SigLIP (siglip_vision_patch14_384.safetensors)。

VAE: 标准VAE (vae.safetensors)。

三、工作流搭建步骤

1.加载输入与创建遮罩:

Load Image加载图A (主体,如沙发)。

Load Image加载图B (场景,如客厅)。右键此节点 -> Open in MaskEditor,仔细涂抹图B中需要被替换的区域 (如客厅里的旧沙发),完成后保存关闭编辑器,生成Mask。

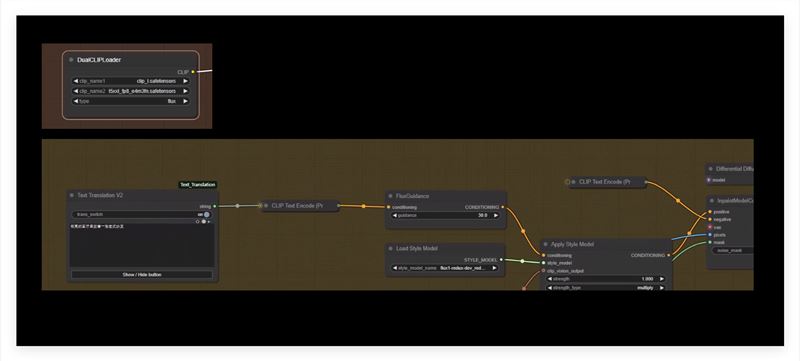

2.配置Flux文本编码:

使用DualCLIPLoader加载T5 和CLIP-L,type设为flux。

编写Positive/Negative Prompts,连接到CLIP Text Encode (Prompt)。

连接 Positive Prompt到FluxGuidance调整引导强度。

3.应用Redux (学习图A特征):

连接Load Style Model (Redux 模型) 和Load CLIP Vision。

将图A的IMAGE 输出连接到CLIP Vision Encode。

将文本Conditioning (来自FluxGuidance 或 CLIP Text Encode) 连接到Apply Style Model的conditioning输入。

将Redux模型和CLIP Vision输出也连接到Apply Style Model。获取增强版Conditioning 输出。

4.准备Inpainting (整合信息):

加载Load VAE。用VAE Encode处理图B(获取Latent)。

将Mask(来自图B的Load Image节点) 连接到InpaintModelConditioning的mask输入。

将图B的Latent连接到InpaintModelConditioning的latent输入。

将增强版Positive Conditioning (来自 Redux) 连接到InpaintModelConditioning的positive输入。

将Negative Conditioning连接到InpaintModelConditioning的negative输入。

5.执行采样 (生成新图像):

加载Load Diffusion Model (Flux Fill模型)。

将Fill模型连接到KSampler。

将InpaintModelConditioning的三个输出 (positive, negative, latent) 连接到 KSampler对应输入。

设置KSampler参数 (steps=20, cfg=3.0, denoise=1. 0 等,根据需要调整)。

6.解码预览:

连接KSampler的LATENT到VAE Decode。

连接VAE Decode的IMAGE到Preview Image查看最终成果!

7.应用场景拓展

掌握此流程,你可以轻松实现:

虚拟试戴首饰: 图A=项链,图B=人像,Mask→脖子。

服装更换: 图A=衣服图片/图案,图B=模特,Mask→衣服区域。

材质替换: 图A=木纹/皮革纹理,图B=物体表面,Mask→该表面。

8.小贴士

Mask精度至上: 遮罩边缘越平滑、越贴合,融合越自然。

Redux strength: 在Apply Style Model节点里调整此参数,控制图A的“存在感”。

Prompt辅助: 简洁描述最终场景有助于AI理解,例如“A vintage sofa in a bright living room”。

book mark(rgthree):在复杂的工作流中创建命名的导航锚点,能通过书签快捷键快速跳转到图中的特定区域,方便查看和编辑。

四、结语

ComfyUI结合了Flux. 1 强大基础和黑森林工作室Redux+Fill精准工具,让“万物迁移”变得触手可及且效果惊艳。现在,就打开ComfyUI,动手实践吧!探索不同参数组合,释放你的创造力,看看你能用这个强大的工具组合创造出怎样惊艳的效果!

工作流下载:(点击下载)

8

AI教程交流群

扫描二维码加入群聊

与同行学习交流&资源共通

© CopyRight 2002-2024 ,CHINAZ.COM , Inc.All Rights Reserved.