ComfyUI ICEdit教程:轻松实现AI图像智能编辑

5/12/2025, 9:24:19 AM | 热度:980 | 阅读本文需 8 分钟

点赞

作为一款强大的节点式AI图像生成界面,ComfyUI为我们提供了无限的创作可能。今天,我们将聚焦于一项最近比较热门的技术——In-Context Edit (ICEdit),它能让你像与设计师对话一样,通过简单的文本指令,智能地编辑你的图像,而无需繁琐的蒙版操作。本篇ComfyUI ICEdit 教程将带你一步步了解其工作流程和核心理念。

什么是 In-Context Edit (ICEdit)?

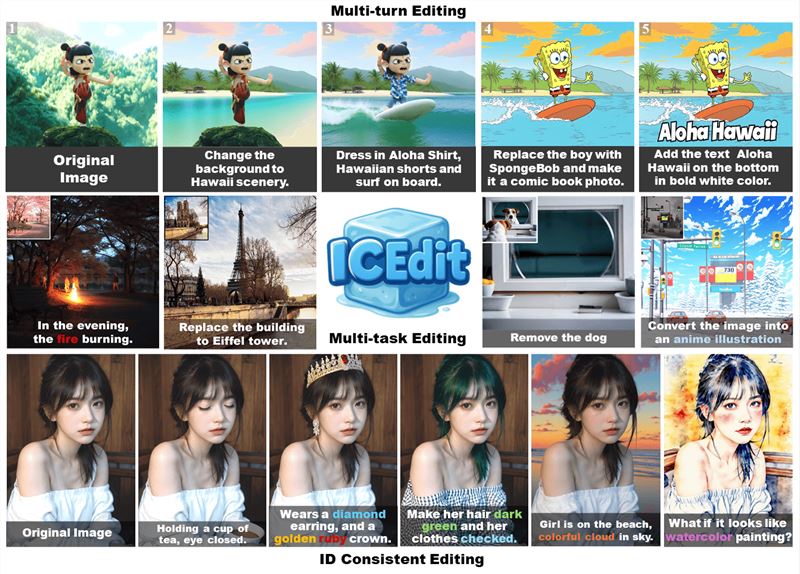

简单来说,In-Context Edit (ICEdit) 是一种AI图像编辑方法,它能够理解你提供的原始图像、原始图像的描述(源上下文)以及你希望进行的编辑指令(目标上下文)。基于这些信息,ICEdit可以精准地修改图像的特定部分,同时最大限度地保留未编辑区域的细节和整体风格。其最大的魅力在于“上下文感知”和“无需蒙版”,这使得AI图像编辑变得前所未有的直观和高效。

技术架构

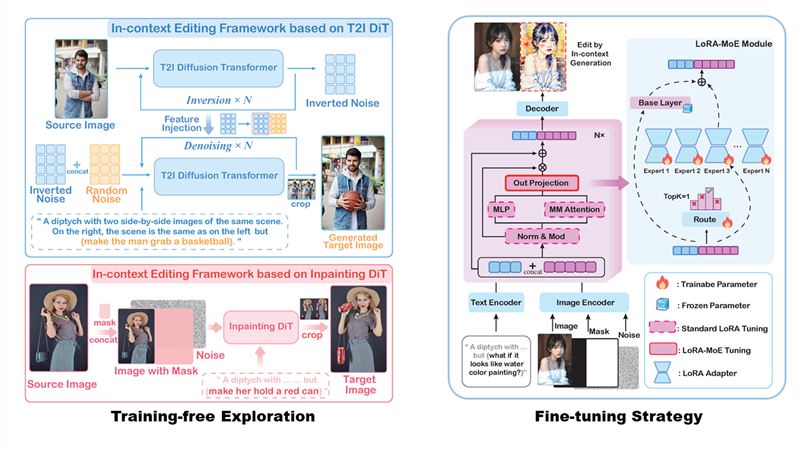

ICEdit采用了基于 DiT( FLUX)实现了一种无训练的上下文编辑范式,模型通过处理 “上下文提示” 和源图像(左面板)来生成编辑输出(双联画的右面板)。尽管仍存在一些持续的失败案例,但实现的优势建立了一个强大的基线,有助于通过高效的微调来提高精度。在 DiT 框架内实现了参数高效的 LoRA 适配器和混合专家(MoE)路由,这在编辑过程中动态激活特定任务的专家。该模型在最少的公开数据(5 万)上进行训练,无需架构修改或大规模再训练,即可在多种场景下提高编辑成功率。同时ICEdit还设计了一种推理时间扩展策略以提高编辑质量。更多详细信息,点击前往项目页面。

ICEdit项目页面:请点击此处前往查看

ICEdit仓库地址:请点击此处前往查看

ICEdit节点页面:请点击此处前往查看

Lora地址:请点击此处前往查看

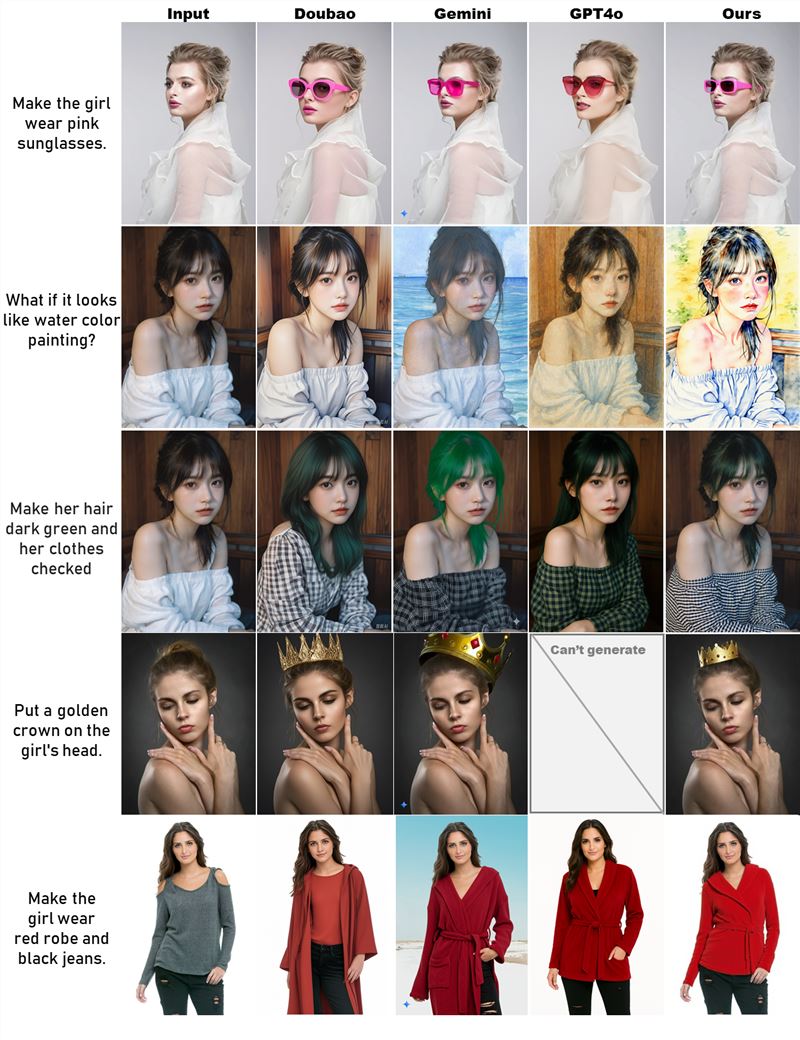

与商业模型的比较

一个完整的In-Context Edit工作流主要包含以下几个核心阶段:

阶段一、节点安装、模型下载

1.节点:可直接在github下载zip(点击此处前往下载),然后解压放置ComfyUI\custom_nodes文件夹中。

2.模型:black-forest-labsFLUX模型(点击此处前往下载)、normal-lora(点击此处前往下载)、放大模型(点击此处前往下载)

阶段二、:初始化与指令输入 (源图像与编辑意图的明确)

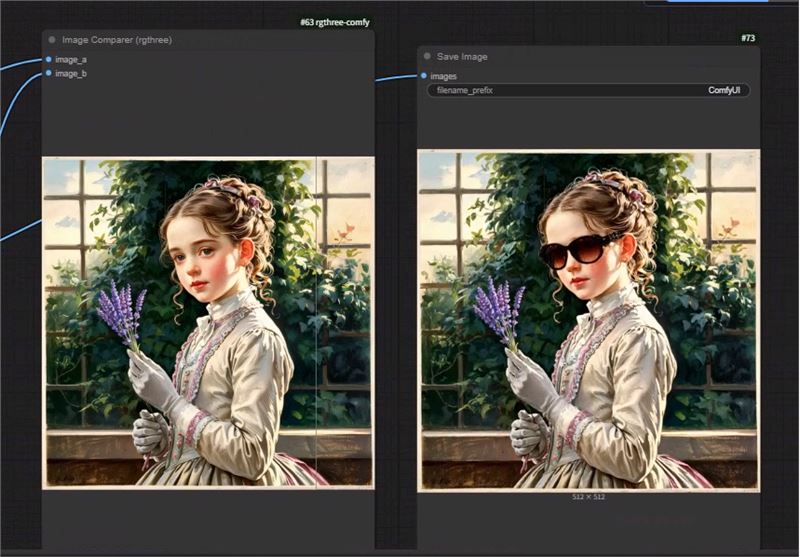

这是整个编辑过程的起点。作者内置在ICEdit模块中示“带有同一场景的两个并排图像的双联画......但是“,只需输入具体编辑指令,例如 ”Make the girl wear pink sunglasses”

理念:你需要告诉AI“我希望把它变成什么样”。

重点:

提供编辑指令: 在示例中,我们看到一个InContextEditInstruction节点,用户输入了编辑指令,例如图中的 "remove the text" (移除文字)。这个指令清晰地表达了期望的效果。

示例:

风格转换:convert the image into anime illustration

修改服装颜色:change the white shirt to xxxx color

修改发型:change the girl hair to xxxxxx hair

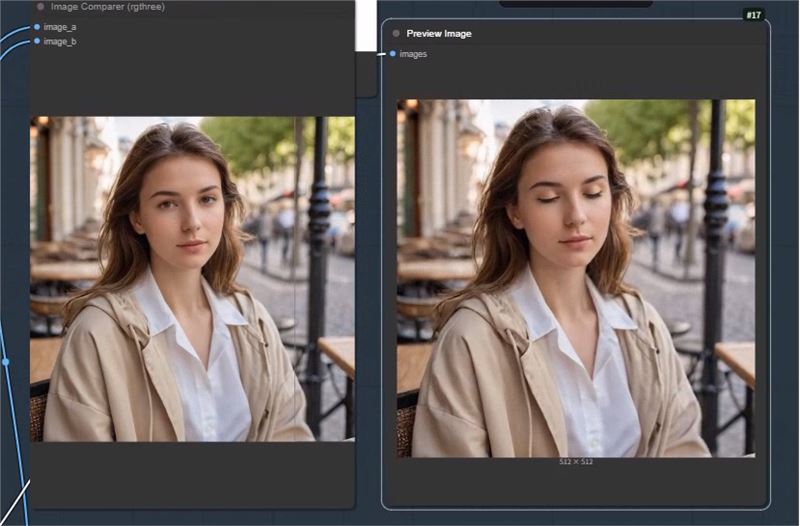

小幅度修改姿态:make the girl eyes closed,make the girl smlie

增加物品:the girl wears/ a cat

移除物品/文字/水印:remove picture the xxx/text/watermark

1.Make the girl wear hat.

2.Change the white shirt to brown color.

3.Change the girl hair to Shoulder-length short hair.

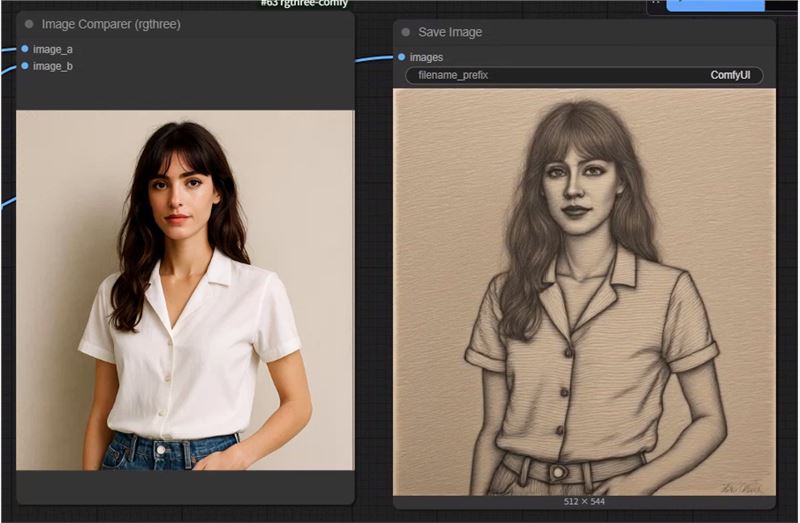

4.Change the style from realistic to pencil sketch style.

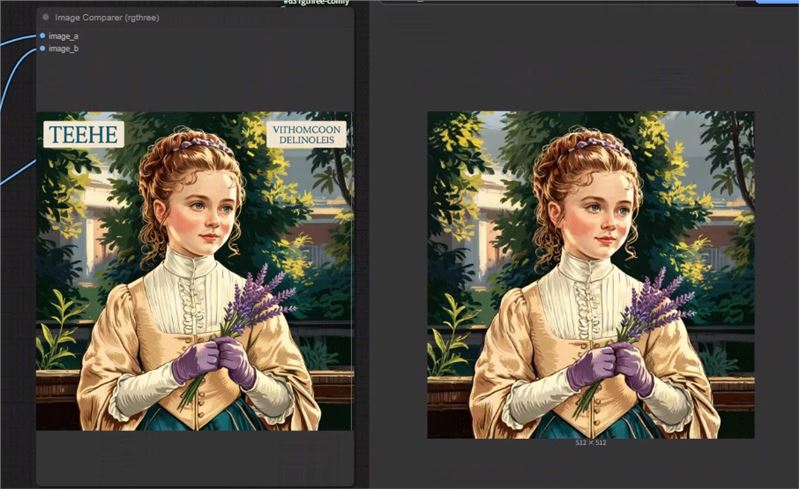

5.Remove the text.

6.Change the Purple lavender to white lilies in her hand.

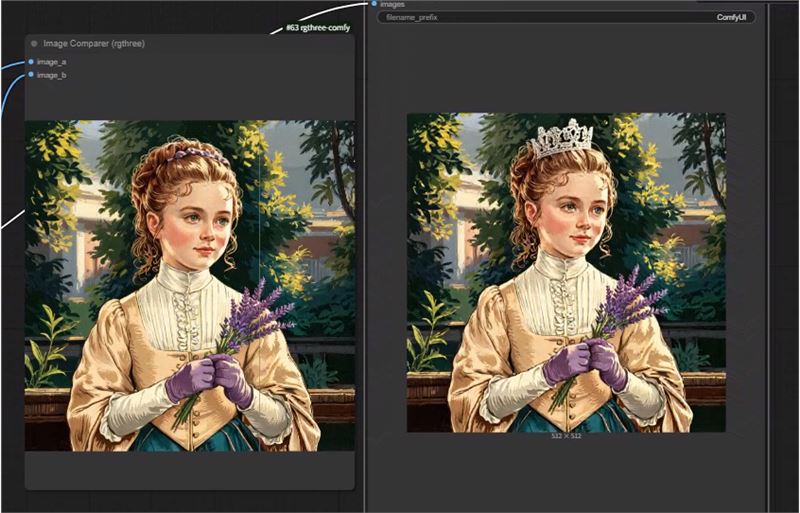

7.Put a crown on the girl's head.

8.Make the girl wear sunglasses.

9.Make the girl eyes closed.

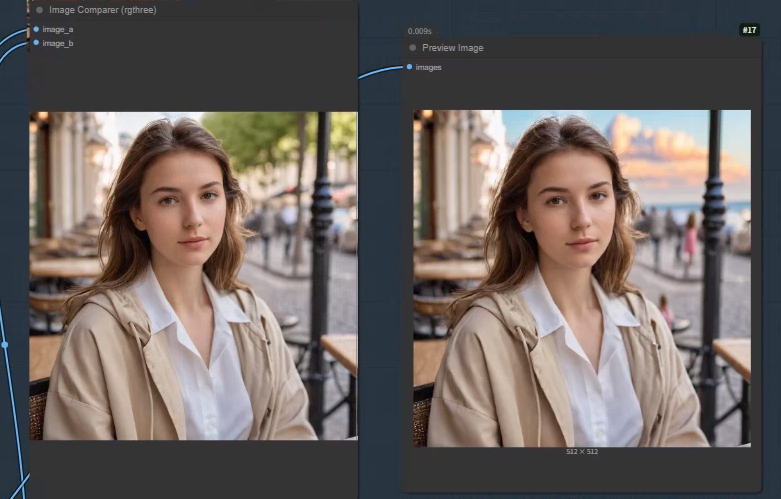

10.The girl is on the beach,colorful cloud in the sky.

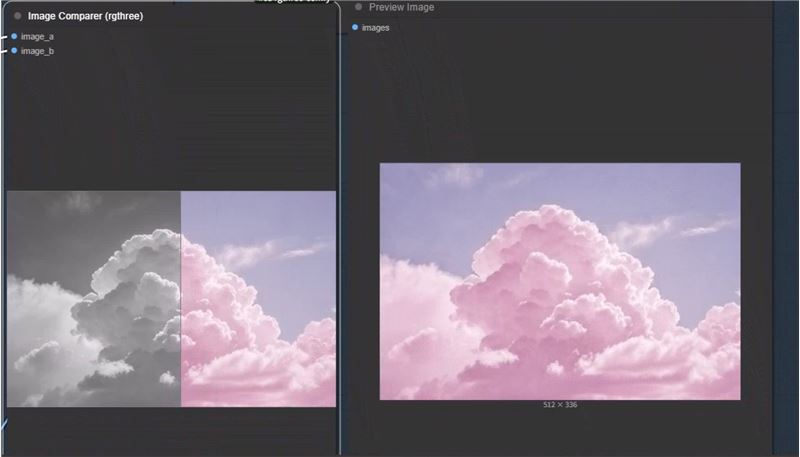

12.Convert the image into a blue sky with pink clouds.

阶段三:ICEdit核心处理与模型加载 (上下文理解与模型准备)

当AI获取了原始图像和你的编辑意图后,ICEdit的核心模块开始工作,并加载必要的AI模型。

理念:ICEdit模块解析上下文,并结合各种AI模型(如CLIP用于理解文本,UNet作为扩散模型的核心,VAE用于图像编解码)的能力,为后续的图像生成做准备。

重点:

模型加载:工作流中加载基础的扩散模型(如FLUX模型、Stable Diffusion模型)、CLIP文本编码器、VAE图像编码器/解码器,以及可能的LoRA模型(用于风格或特定对象微调)。这些模型的质量和兼容性直接影响最终效果。

ICEditConditioning节点:这是实现上下文编辑魔法的核心。它接收来自DiptychCreate节点的图像信息、编辑指令(经过CLIP编码后形成的In_context),以及常规的正负向提示词、VAE等。它的任务是智能地将编辑意图融入到图像的潜在表示中,并生成引导后续K采样器进行特定编辑的条件。

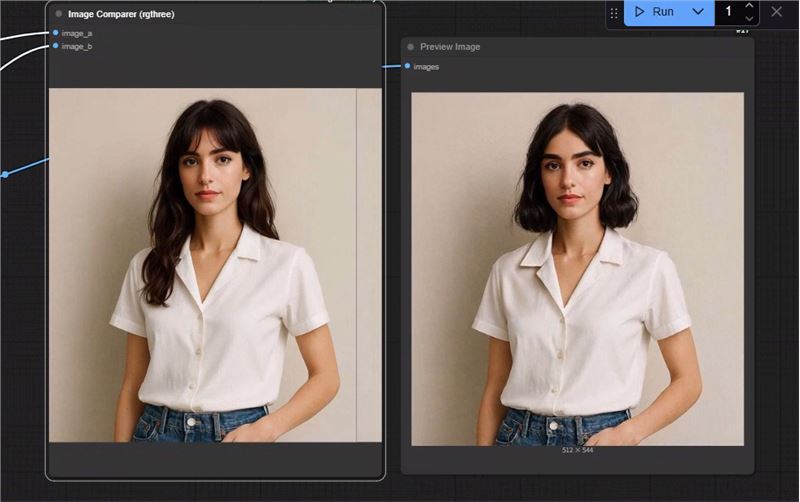

阶段四:图像生成、优化与预览 (实现编辑并输出结果)

万事俱备,只欠生成。

理念:利用前面准备好的条件和潜在表示,通过采样器(如KSampler)生成编辑后的图像,并可能进行后续的优化(如放大)。

重点:

K采样器 (KSampler):这是实际执行图像生成步骤的节点。它根据ICEditConditioning节点输出的引导信息(新的正负向提示和编辑后的潜变量),逐步从噪声生成符合编辑要求的图像。采样步数、CFG Scale、采样器类型等参数都会影响输出质量。

图像放大(可选):如果需要更高分辨率的输出,可以使用放大模型(如ESRGAN、SwinIR等)对生成图像进行放大处理。

ICEdit的核心优势与注意事项

上下文感知 (Context-Aware):ICEdit真正理解你原始图像的内容和结构,编辑时会努力保持整体的协调性。

无需蒙版 (Mask-Free):大大简化了编辑流程,你不需要预先绘制精确的选区。

宽度限制:模型只能编辑宽度为 512 像素的图像(对高度没有限制)。如果传入的图片宽度不是 512 像素,模型会自动将其大小调整为 512 像素。

清晰的编辑指令至关重要:你的文本指令越清晰、越具体,AI就越能准确理解并执行你的意图。

模型选择与兼容性: 确保你使用的基础模型、VAE以及ICEdit适配器模型(如果有特定版本)是相互兼容的。例如,工作流中使用了FLUX系列模型,确保所有相关组件都支持FLUX。

迭代与调整:AI创作往往需要多次尝试。调整编辑指令、采样参数,甚至更换LoRA,都可能带来意想不到的效果。

总结

本篇ComfyUI ICEdit教程介绍了其原理与ComfyUI工作流。与当前AI图像编辑技术类似,ICEdit也面临挑战:指令理解,对复杂或模糊指令的理解尚不完美。细节与一致性,精细纹理、复杂结构生成及编辑后光照/风格一致性仍待提升。这些是AI图像编辑领域的普遍瓶颈,但ICEdit本身已是重要进步,并有望随技术发展持续改善。若效果不佳,可尝试调整--seed参数以获得满意结果。总之,ICEdit使AI图像编辑更智能便捷,让创作者能更专注于创意表达。本指南旨在帮助零基础用户快速上手,在ComfyUI中运用ICEdit创作生动的AI艺术。如需工作流文件,(点击下载)。

在线运行,请点击此处前往。

0

AI教程交流群

扫描二维码加入群聊

与同行学习交流&资源共通

© CopyRight 2002-2024 ,CHINAZ.COM , Inc.All Rights Reserved.