介绍

本文介绍了Stable Diffusion中【controlNet】Reference的使用方法,帮助用户在AI绘图中实现精准的风格和内容参考。

引用官方对参考的介绍:现在我们有一个 reference-only预处理,它不需要任何控制模型即可实现直接使用一张图片作为参考来引导扩散。

关于reference-only的官方介绍:https://github.com/Mikubill/sd-webui-controlnet/discussions/1236

在我看来这个功能有点类似于Midjourney的垫图,很多controlnet的功能都有垫图的效果

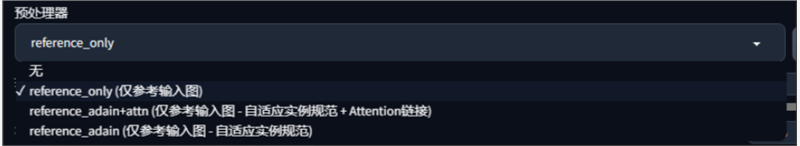

预处理器介绍

由于reference是由算法控制,所以是没有控制模型的只有3个预处理器

reference_adain:仅参考输入图,自适应实例规范。简单来说就生成的图更偏向模型

reference_adain+attn:仅参考输入图,自适应实例规范+Attention链接。这个预处理器相当于另外两个算法的综合。

reference_only:仅参考输入图。这种是最大程度的参考我们的素材图片。一般使用的就是这个预处理器,本文主要介绍的也是这种

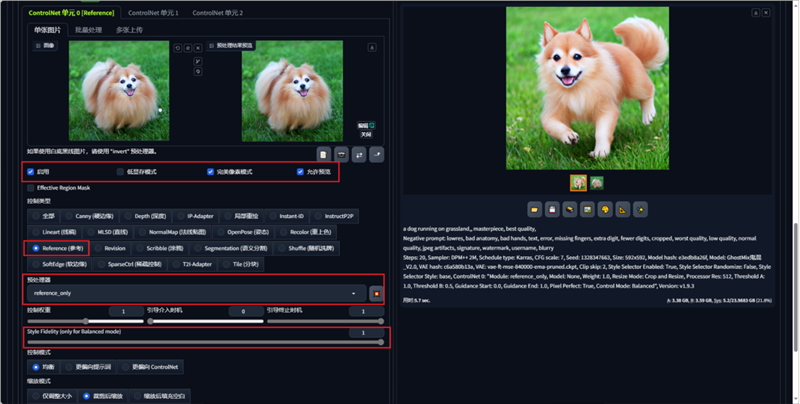

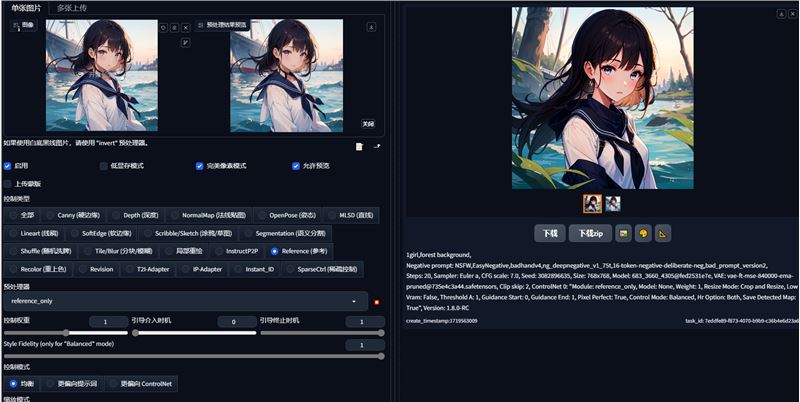

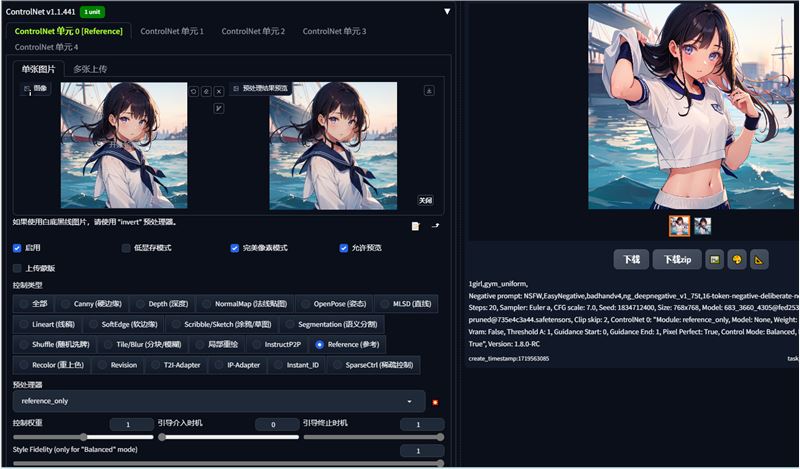

使用方法

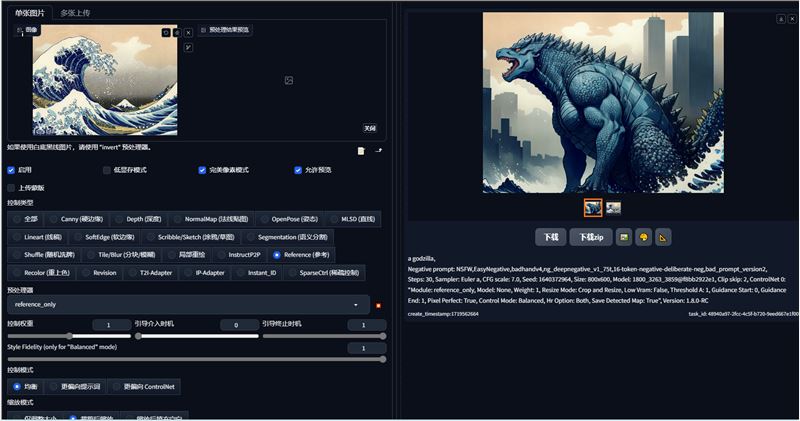

ControlNet按图片进行配置,Style Fidelity需要设置成1

Style Fidelity (only for "Balanced" mode)是最终要参考图片的一个权重,最小 0 最大1,可以根据需要调整数值;

建议把完美像素也勾上。

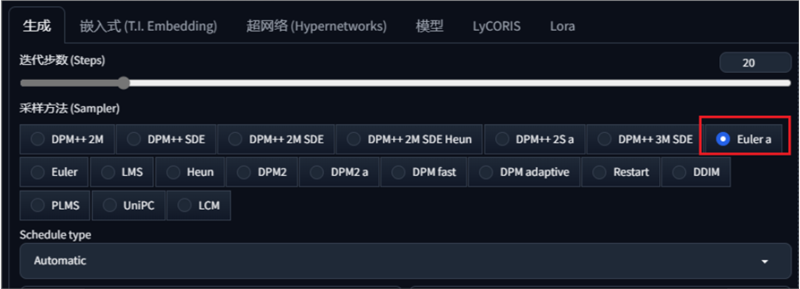

提示词简单描绘:一只在草地上奔跑的狗+基础起手式,采样方法使用Euler a。点击生成

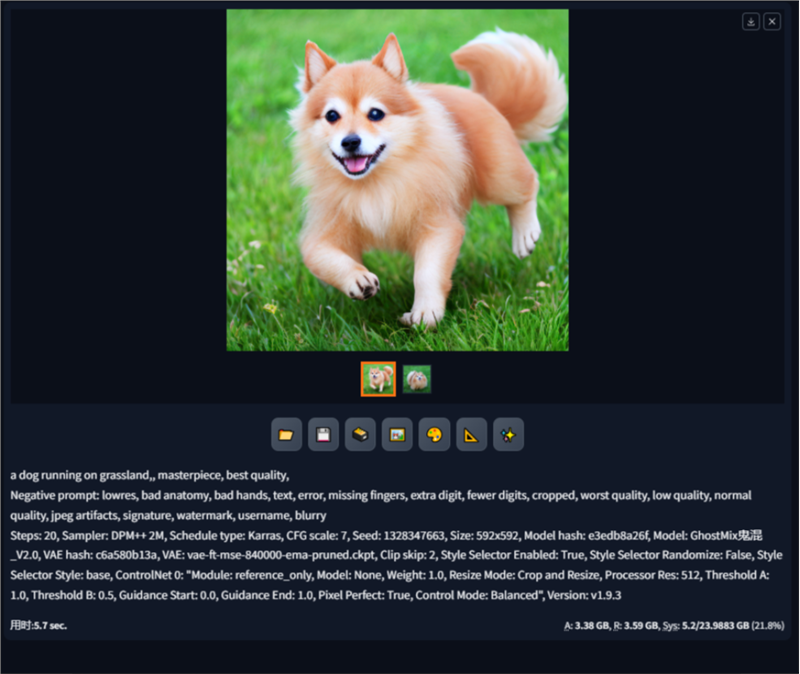

可以看到生成的狗和参考图的狗还是比较相似的,特别是面部纹路,但是我们的引导词中没有描述狗的品种、颜色,也没有使用任何lora或者专门训练的底模,这样的生成结果已经达到了预期,当然还是有一定的随机性,可以通过多次生成筛选,或者多次迭代prompt,优化生成结果应该也不难。

这一张是我结合神奈川冲浪里的效果制作的哥斯拉,可以看到哥斯拉的身边的水花还有画面的整体色调都参考了右图,而我提示词只用了哥斯拉一个关键词,并没有多余的控制

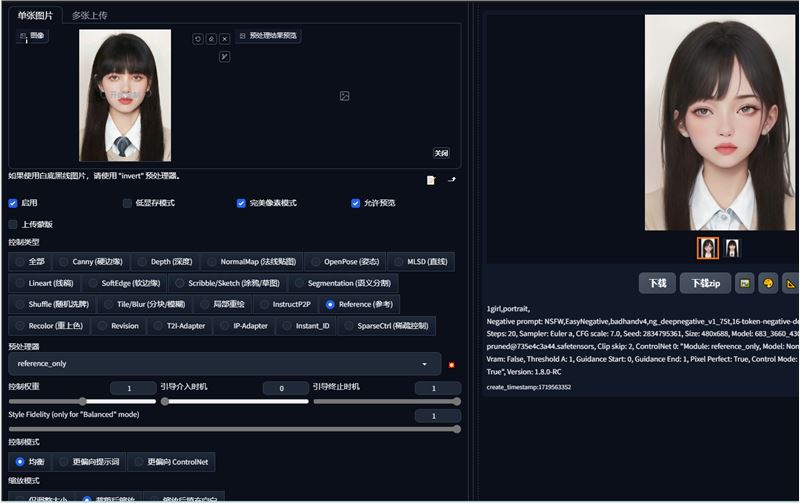

我们也可以使用这种方法把真人照片转化为动漫人物

我们只要使用真人的照片,然后配合上动漫风格的模型即可

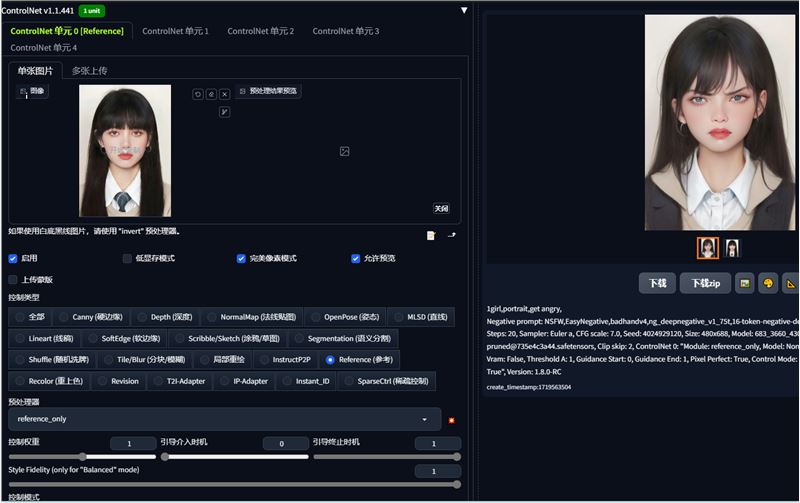

我们也可以添加提示词来控制人物的表情,比如我添加了生气

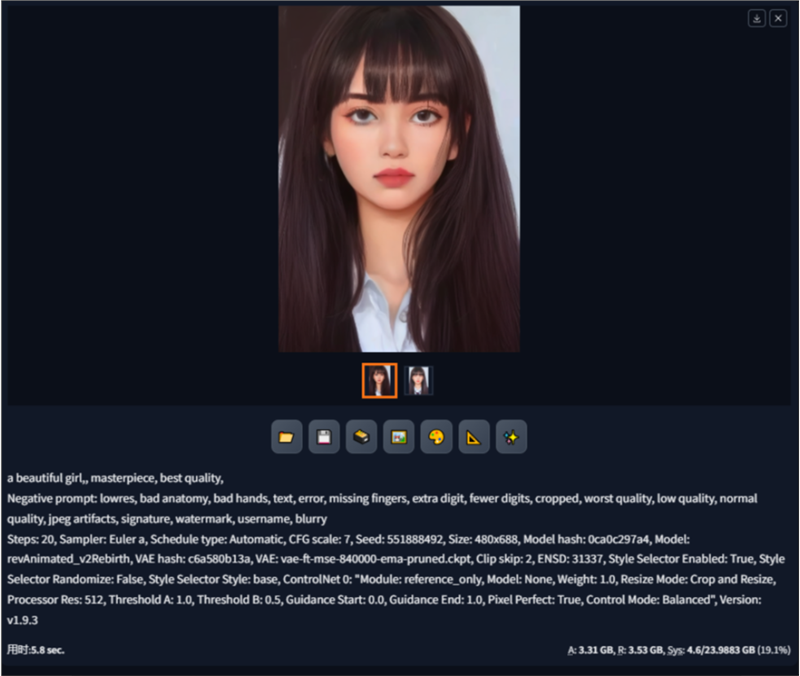

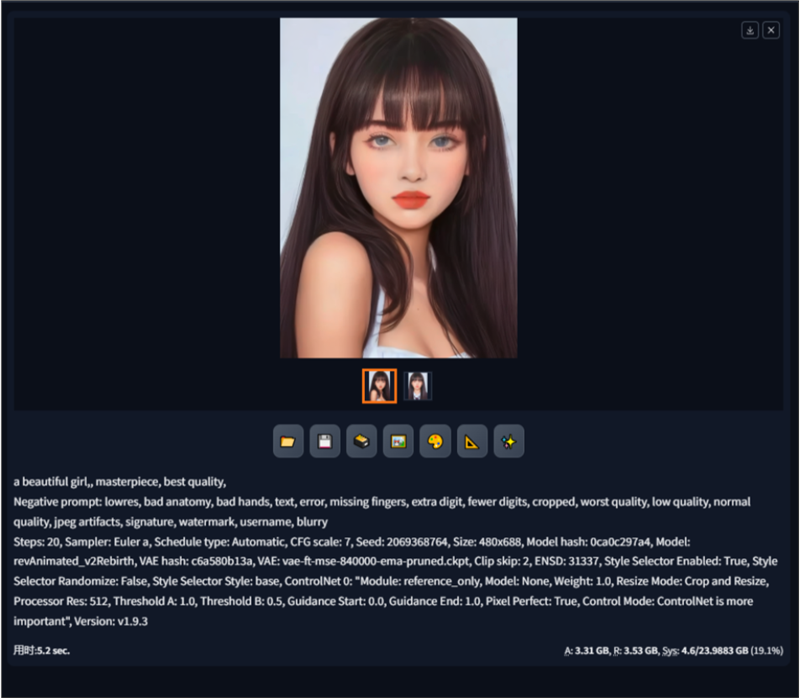

以下是RevAnimated模型的效果

生成的结果还是非常相似的,除了眼睛部分有点模糊

此外我们还可以使用reference更换人物的背景或者服装

可以看到人物和原图还是非常相似的,背景替换了,虽然衣服的部分没有处理好,我们也可以换一件衣服试试

以上就是reference的常见用法,感兴趣的小伙伴赶紧也去试试吧

0

© CopyRight 2002-2024 ,CHINAZ.COM , Inc.All Rights Reserved.