Stable Diffusion 3解析

5/31/2024, 4:38:55 PM | 热度:22 | 阅读本文需 3 分钟

点赞

什么是 Stable Diffusion 3 模型?

Stable Diffusion 3 是 Stability AI 发布的最新一代文本到图像 AI 模型。它不是一个单一的模型,而是一个从800M到8B参数的模型系列。换句话说,最小的模型比 Stable Diffusion 1.5 (1B) 小一点,最大的模型比 Stable Diffusion XL 模型大一点(基础 + 精炼器为 6.6B)。

Stable Diffusion 3 有什么改进

文本生成

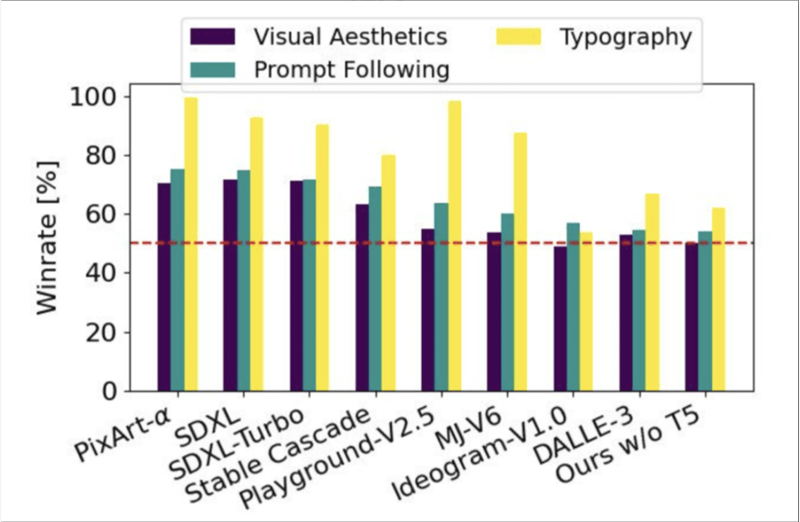

更好的文本生成长期以来,文本渲染一直是 Stable Diffusion 的弱点。Stable Diffusion 1.5 真的很糟糕。

我们看到 Stable Diffusion XL 和 Stable Cascade 模型有了显着改进,但它们仍然是不准确的,需要大量的挑选。对于长句子来说是没有希望的。

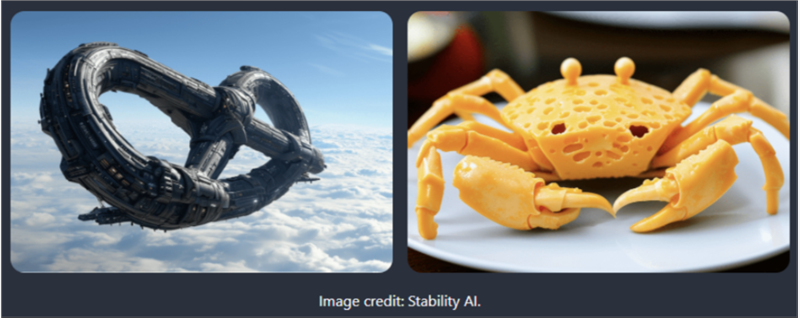

看看 SD 3 可以产生什么:

从样本图像中,我们看到了一些令人印象深刻的长句子,字体风格很好。我绝对认为这是一个改进,因为我们永远无法用SDXL或Stable Cascade生成这些图像。

提示跟踪

SDXL 和 Stable Cascade 的一个突出问题是它们不像 DALLE 3 那样遵循提示。DALLE 3 的一项创新是在训练中使用高度准确的图像标题来学习很好地遵循提示。

在用户研究中,Stable Diffusion 3 在提示跟踪方面与 DALLE 3 相当。(稳定性 AI)

在以下提示中,Stable Diffusion 3 应至少与 DALLE 3 一样好。这将是令人兴奋的。

速度和部署

如果你有一个24 GB RAM的显卡,你将能够在本地运行最大的SD3。

对于RTX4090 视频卡上的1024× 1024 图像,初始基准测试是 34 秒( 50 个步骤)。

Stable Diffusion 3 模型中的新增功能

噪声预测 SD

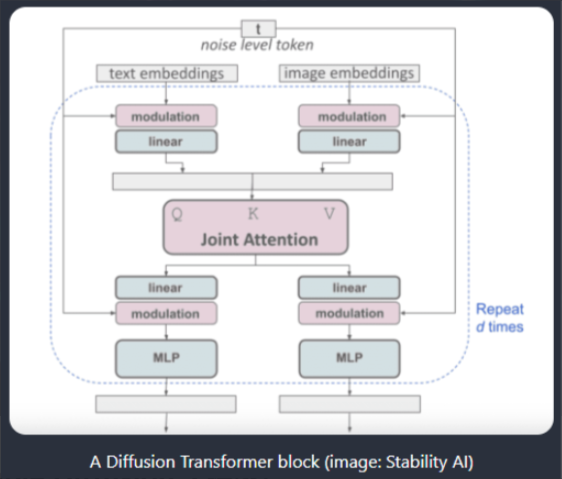

SD3 中一个显著的变化是与 SD1 和 2 中使用的U-Net噪声预测器架构不同。

SD3 使用扩散变压器的重复堆栈。其好处类似于在大型语言模型中使用转换器:随着模型大小的增加,您可以获得可预测的性能改进。

该块有一个有趣的结构,将文本提示和潜在图像放在相同的基础上。看起来这个架构很适合添加多模态条件,比如图像提示。

采样

Stability 团队花费了相当多的精力研究采样,以使其快速和高质量。SD3 使用固定流采样。基本上,它是一条从噪声到清晰图像的直线路径——到达那里的最快方式。

研究小组还发现了一种噪声时间表,它对路径的中间部分进行采样,可以产生更高质量的图像。

看起来 采样结果会完全不同。但从我们的经验来看,一些现有的采样器可能工作得很好。

文本编码器

Stable Diffusion1 使用 1 个文本编码器(CLIP),而Stable Diffusion XL使用 2 个编码器(CLIP和OpenCLIP)。而 SD3 使用 3 个编码器!分别是:

OpenAI的CLIP L/14

OpenCLIP境/ 14

T5-v1.1-XXL

最后一个非常大,如果您不生成文本,则可以删除它。

怎么使用

Stable Diffusion3 目前官方只开放了API接口,我们普通人很难通过API直接使用。不过现在liblibAl已经正式上线了V3 模型,所以我们可以直接在liblibAl上使用。

使用体验还是非常不错的,感觉比 Midjourney 还方便。生图也非常的准确,质量也很高。

0

文章目录

什么是 Stable Diffusion 3 模型?

Stable Diffusion 3 有什么改进

Stable Diffusion 3 模型中的新增功能

怎么使用

AI教程交流群

扫描二维码加入群聊

与同行学习交流&资源共通

© CopyRight 2002-2024 ,CHINAZ.COM , Inc.All Rights Reserved.